年前使用了 DeepSeek V3,总体比我当时使用的 AI 软件好用,就切换工具了。也蛮神奇的,过年 DeepSeek 突然火了——新发布的 R1 模型性能和成本过于惊人了。

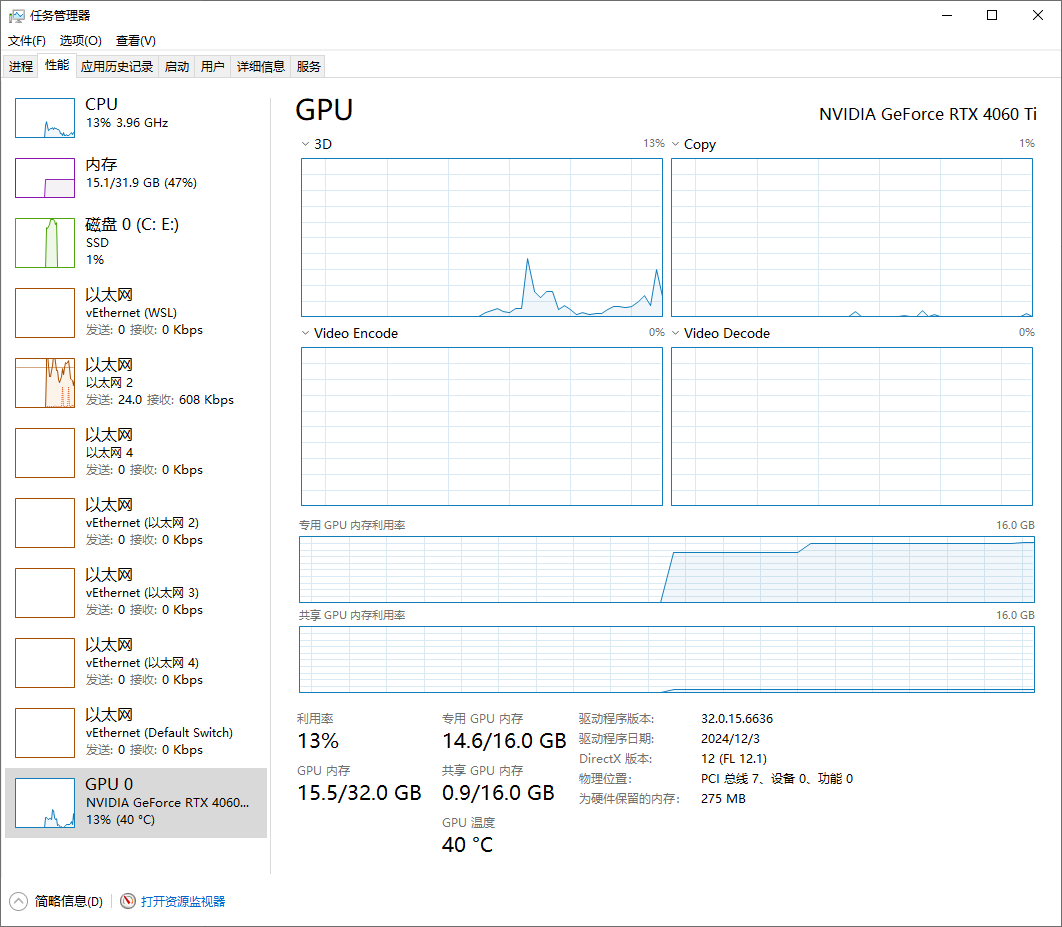

看了一些本地搭建的资料,所需的资源台式机能够支持(4060ti 16G,没错,这张显卡买了很久,现在终于来实现购买它的目标了),想用它处理一些本地数据,就着手搭建了。

搭建相关资料网上很多,我就不赘述了,只讲一下个人经验。

一、软件选择

1. 模型

在 HF-Mirror 或 ModelScope 魔搭 下载模型。

极限使用 DeepSeek 32B 蒸馏的 Q3_K_M,但尝试的效果并不算好,Q2 还乱回复了。

最后就选择 14B 蒸馏的 Q6_K_L 了,效果能接受。

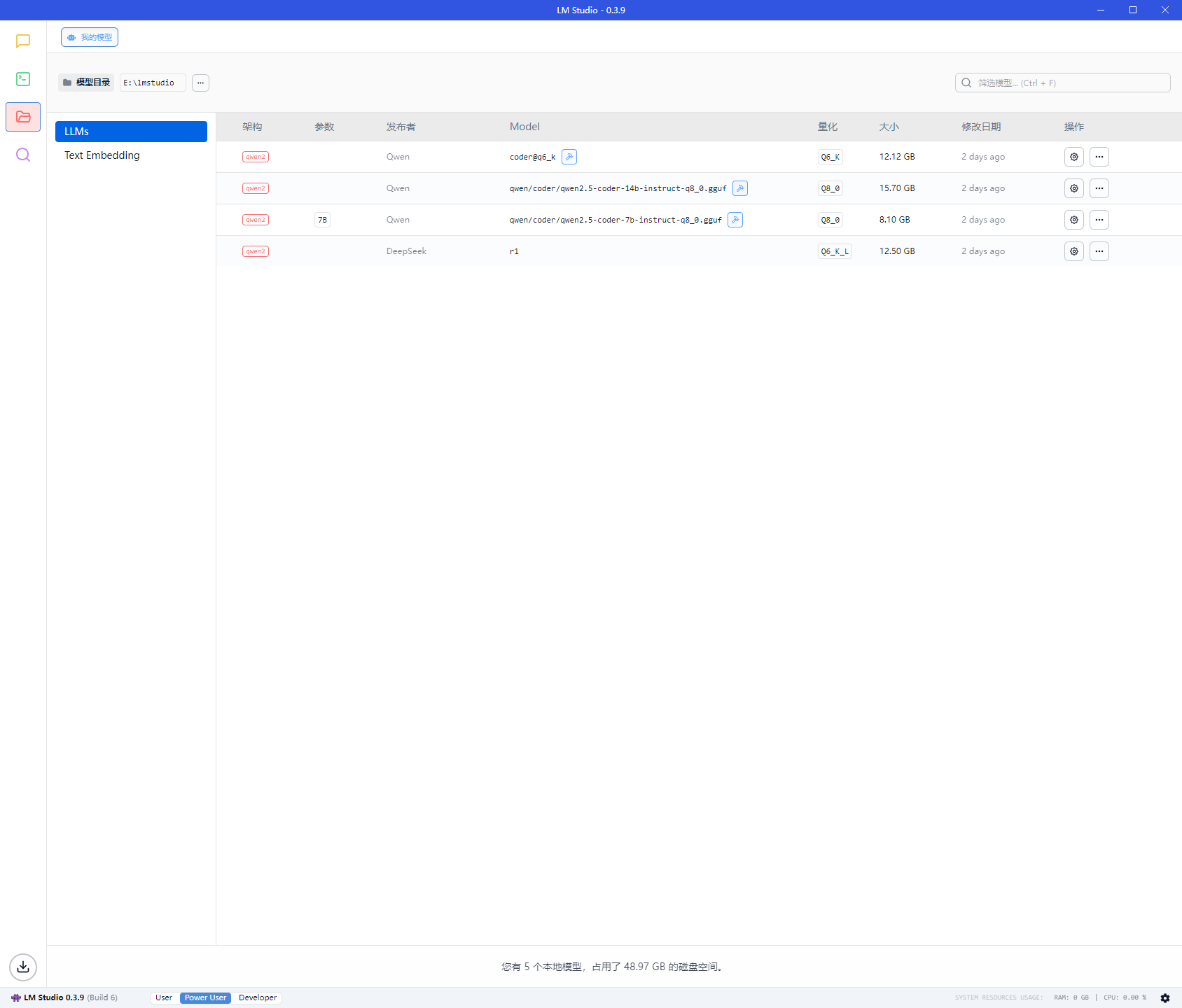

2. LM Studio

最开始尝试了 LM Studio,界面舒适,自带聊天框,不需要额外安装软件。

但性能有一些问题,跑模型的时候内存没有超过 16G,没有使用交换内存,按理来说完全跑在显卡上,回答速度是没问题的,但它就是回答的很慢。

我知道 LM Studio 肯定会多一些性能损耗,但这些损耗应该在可控范围内,不应该出现这种情况。

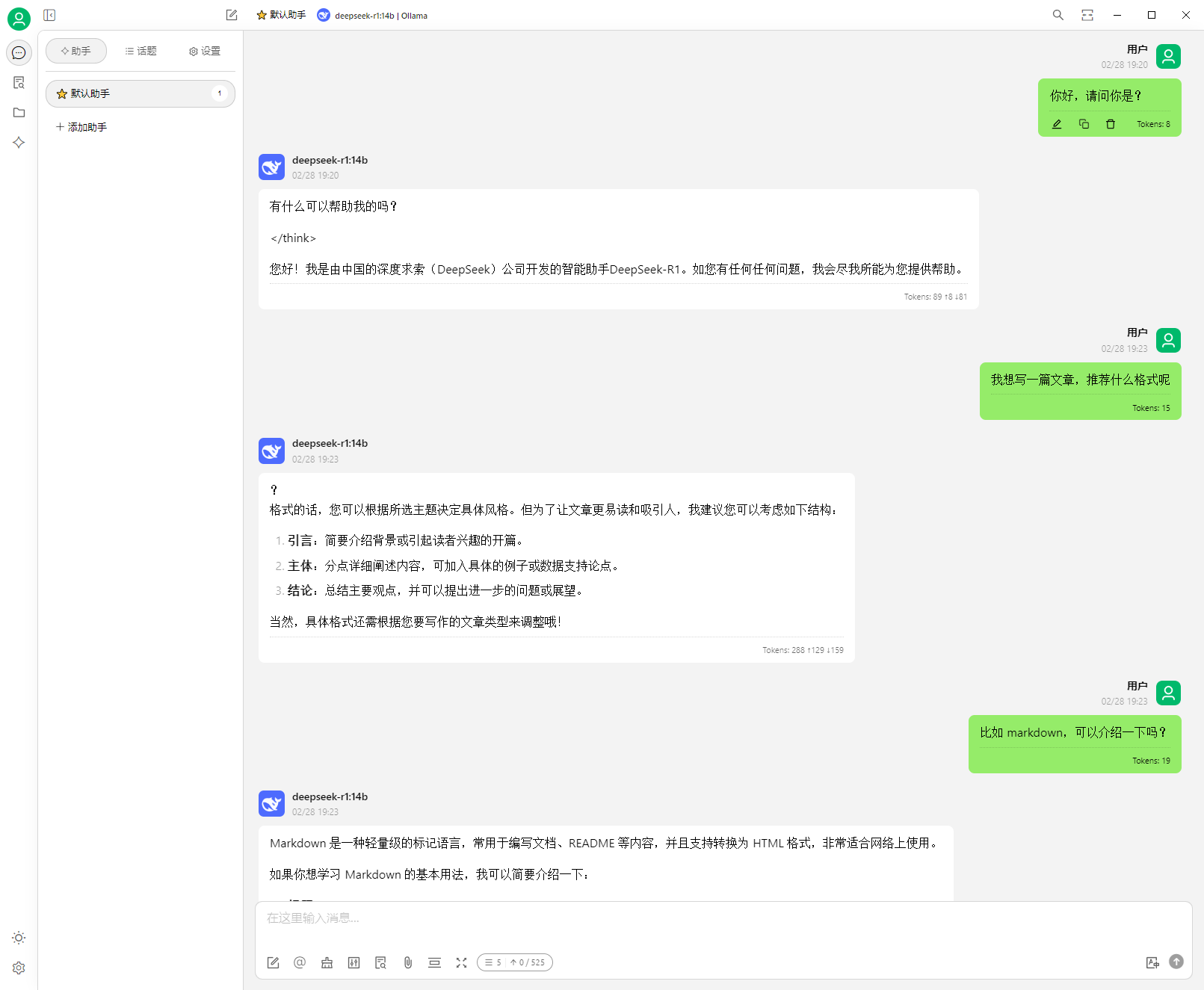

3. Ollama

切换到 Ollama,神奇的事情出现了,同一个模型,回答速度正常了。

所以我选择了 Ollama 。

4. Cherry Studio

是我试用各个聊天框软件,感觉最全面的一个。

LM Studio 比 Ollama 好用的一个点,是能在 UI 界面上方便切换模型,而惊喜的是,Cherry Studio 在选择不同聊天时,模型会自动切换。这样就打消了我最后一个顾虑。

所以我选择了 Cherry Studio 。

5. 最终搭配

最终选择 Ollama + Cherry Studio 组合来运行本地模型。

回答速度适合

性能消耗正好达到边界

二、实际应用

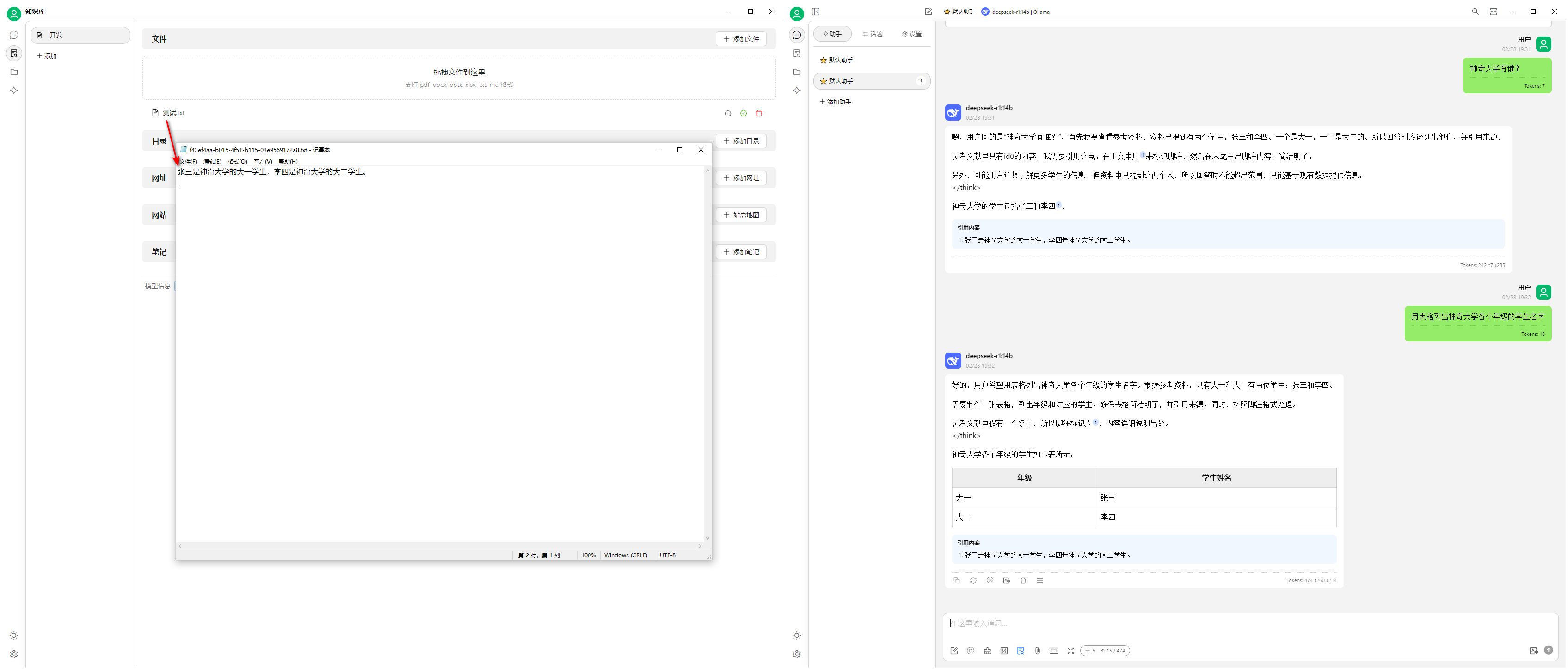

1. 本地知识库

Cherry Studio 可以直接搭建本地知识库,效果不错,不需要使用 AnythingLLM。这样一个软件同时拥有聊天框、本地知识库等功能。

记得安装向量模型,比如 Nomic-Embed-Text。

我认为这个应用非常适合个人在本地搭建。一个适中的模型,就可以提供很大的便利。

2. 代码

我尝试了Qwen Coder 2.5、Claude 3.5,配合 VSCode 相关插件如 Cline,看看能否完全本地化,但效果并不好,感觉还是很基础的修改,没有联动。

而使用外部 API 的 Cursor 的 Claude可以理解我的想法,做一些重复操作,我 review 代码时只需要少量改动。另外,要注意代码安全,外部 API 总归是不安全的。如果是修改开源代码,就不用顾虑太多了。

我认为依靠本地知识库,投喂一些代码文档资料,让本地 AI 帮助分析可能会更有用些。让它做想要的修改效果,可能有些难为它了(与我的显卡是入门级,模型体量不足也有关)。

三、总结

目前来说,一般情况不建议个人在本地部署,直接用官方满血版比本地版好太多。如果搭建本地知识库,是推荐的,效果不错。

明确你的目的是部署成功还是本地应用。